中心新闻

构建新的连续型深度时滞神经网络

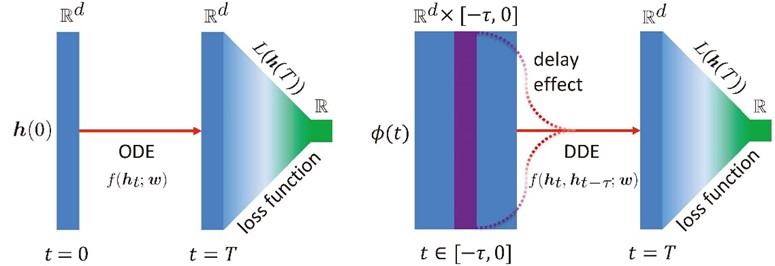

林伟团队有关新型人工神经网络架构的文章"Neural Delay Differential Equations"被人工智能与机器学习领域国际顶级学术会议Ninth International Conference on Learning Represenetations (ICLR 2021)于2021年1月15日正式接收。在深度神经网络和深度学习的领域中,近期最受关注的框架是将离散型神经网络转换为连续型构架。这一非平凡转换有助于显著提升神经网络的计算效率与逼近能力,受到了学界以及应用领域的广泛关注。林教授团队将信息处理的时滞效应引入连续型神经网络架构,将原本连续网络的有限维逼近能力本质地提升至无限维逼近能力,根据无限维系统理论证明了这一逼近能力,并利用控制理论给出了系统参数估计的可计算伴随形式。这一连续型深度时滞神经网络可以在非常低维的输入变量设置下实现函数型以及复杂动力学数学的拟合与分类,切实促进了深度神经网络领域实质发展,为一系列复杂计算问题,提供了高效计算的框架和结构。ICLR是人工智能与机器学习领域世界三大顶级学术会议之一,由图灵奖得主Yoshua Bengio 和 Yann LeCun发起举办,采用Open Review的论文评审制度。该会议的谷歌学术 h5 指数已经排到了全榜第17名。本工作也是数学助力人工智能新型框架发展的例证之一。